Metodo di determinazione della copeptina

Marco Caputo

Synlab Med srl, Calenzano (FI)

(aggiornamento marzo 2023)

La scelta di misurare la copeptina al posto di AVP è dovuta alla sua maggiore praticabilità in termini di stabilità e praticità operativa, oltre alla comprovata affidabilità come complemento alla diagnostica delle alterazioni del bilancio dell’acqua.

I metodi più diffusi sono quelli in immuno-fluorescenza omogenea automatizzata, che utilizzano un doppio tracciante fluorescente. L’intensità del segnale è direttamente proporzionale alla concentrazione di copeptina nel campione.

Possibili interferenze:

- sepsi, shock settico, infezioni bronchiali, BPCO e cardio-vasculopatie intercorrenti possono indurre aumenti aspecifici di concentrazione ematica della copeptina;

- terapie con antagonisti della vasopressina, altre patologie che coinvolgano la secrezione di vasopressina, inducono un aumento di concentrazione ematica di copeptina;

- sono stati riportati casi di aumenti di copeptina ectopica prodotta da carcinomi bronchiali;

- l’interpretazione del dato in caso di diabete insipido centrale o periferico può essere complicata dall’incompleta espressione clinica della patologia;

- anticorpi eterofili (specialmente anti-topo) possono produrre risultati inaccurati per sovrastima o sottostima. Il laboratorio dovrebbe essere avvertito in caso di discrepanza del risultato con il quadro clinico.

Campione: plasma in EDTA (tappo lilla). Campioni emolizzati non sono accettabili.

Preparazione paziente: è indicato il digiuno e l’astensione da liquidi, inclusa acqua, nelle 8 ore precedenti il prelievo.

Conservazione: stabile 7 giorni a 4-8°C, dopo va congelato.

Riferimenti

Introduzione alla metodologia epidemiologica e statistica

La variabilità degli esami: precisione e accuratezza

La valutazione degli esami diagnostici: sensibilità e specificità

Incidenza e prevalenza di malattia

La variabilità degli esami: precisione e accuratezza

Romolo Dorizzi1 & Marco Caputo2

1Laboratorio, UO Corelab-Laboratorio Unico di Area Vasta Romagna, Pievesestina di Cesena (FC)

2Laboratorio Chimica Clinica ed Ematologia, Ospedale G. Fracastoro, Azienda USL 20, Verona

Il medico di laboratorio ha cura di scegliere la strumentazione e i metodi più validi, fa in modo che le fasi pre-analitiche (di preparazione del paziente e raccolta e gestione del campione) e di refertazione siano adeguate, e ottimizza l’accuratezza e la precisione dei risultati.

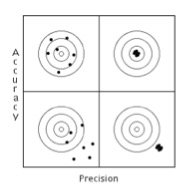

Un metodo si definisce “accurato” quando il risultato è prossimo al cosiddetto “valore vero”, “preciso” quando produce risultati riproducibili.

I risultati analitici sono tuttavia soggetti a errore, indipendentemente dalla qualità del laboratorio e dall’abilità di chi vi lavora. Gli aspetti quantitativi della mancanza di precisione meritano di essere chiariti. Ad esempio, se misuriamo molte volte la concentrazione di ACTH in un campione di plasma con due metodi diversi, uno molto preciso ed uno poco preciso, l’istogramma della distribuzione dei risultati avrà in entrambi i casi un aspetto (normale) gaussiano, ma nel caso del metodo preciso i risultati saranno più concentrati intorno alla concentrazione media. La deviazione standard (DS) è la misura di questa distribuzione intorno al valore medio: la DS è grande se la distribuzione è ampia ed è piccola se la distribuzione è stretta. Per i dati che hanno distribuzione gaussiana, come avviene nel caso degli errori analitici, l’aspetto della curva è completamente definito dalla media e dalla DS. In particolare, si verifica che:

- circa il 67% dei risultati è compreso nell’ambito definito da media ± 1 DS

- circa il 95% dei risultati è compreso nell’ambito definito da media ± 2 DS

- circa il 99% dei risultati è compreso nell’ambito definito da media ± 3 DS.

La figura mostra (in alto a sinistra) un esame accurato, che si avvicina cioè al valore vero, ma è scarsamente riproducibile (i risultati cioè si disperdono intorno al risultato vero), e (i n basso a destra) un esame preciso, in cui i punti si disperdono in un’area molto stretta, ma molto distante dal valore vero (l’esame è poco accurato); in alto a destra un esame accurato e preciso e in basso a sinistra un esame inaccurato e impreciso.

n basso a destra) un esame preciso, in cui i punti si disperdono in un’area molto stretta, ma molto distante dal valore vero (l’esame è poco accurato); in alto a destra un esame accurato e preciso e in basso a sinistra un esame inaccurato e impreciso.

Poiché spesso gli esami ormonali non possiedono entrambe le caratteristiche ideali di accuratezza e precisione, è opportuno impiegare esami accurati per la diagnosi ed esami precisi per il monitoraggio (un esempio potrebbe essere rappresentato dal dosaggio del paratormone nella diagnosi di iperparatiroidismo primario e dalla determinazione della calcemia nel follow-up del paziente dopo paratiroidectomia).

È importante che il medico di laboratorio comunichi ai clinici i dati relativi all’imprecisione analitica dei diversi esami che sono a loro disposizione. Infatti, la tecnologia e l’elettronica hanno consentito progressi nell’automazione, rapidità e riproducibilità degli esami di laboratorio (soprattutto per gli esami immunometrici) ma non sempre nella loro accuratezza.

Mentre le fasi analitiche sono automatizzate, facilmente controllabili e riproducibili (la quota degli errori analitici si aggira consistentemente intorno al 10% di tutti gli errori), le fasi a carico dell’operatore umano sono suscettibili di molte possibilità di errore ed è in questa direzione che devono indirizzarsi gli sforzi per il miglioramento della qualità degli esami endocrinologici.

Sempre maggiore importanza viene data alle cause biologiche di variazione dei risultati. Infatti, la concentrazione di ogni analita, indipendentemente dalla variabilità analitica, non rimane assolutamente costante nel tempo, nello stato di salute e di malattia, ma oscilla intorno ad un punto omeostatico che è specifico del soggetto o generale. Non tutte le cause di questa variabilità sono note ed in alcuni casi tale variabilità può essere molto rilevante.

Tra le cause di variabilità intra-individuale possono essere ricordate:

- l’età, che può influenzare la concentrazione di un costituente del sangue nei primi giorni di vita, durante l’adolescenza e nell’età avanzata;

- la dieta, che influenza molti esami (tra i più classici la curva da carico di glucosio, l’escrezione urinaria di idrossiprolina e di calcio). Vi sono alimenti comuni che hanno effetti particolari e rilevanti. La caffeina, per esempio, aumenta la concentrazione di glucosio e altera la tolleranza al carico di glucosio, riduce il ritmo circadiano del cortisolo, aumenta la concentrazione di sodio, potassio, calcio e magnesio nelle urine;

- le caratteristiche secretorie specifiche dei diversi ormoni, quali il ritmo circadiano che determina concentrazioni diverse nel corso della giornata particolarmente rilevanti per ACTH e cortisolo, e i picchi secretori per il GH;

- la postura: passare dalla posizione supina a quella eretta porta ad una riduzione del volume di sangue del 10%, con conseguente aumento della concentrazione di proteine, enzimi ed ormoni proteici, poiché solo il fluido privo di proteine passa nei tessuti;

- il fumo, attraverso l’azione della nicotina, può influenzare molti esami di laboratorio in modo proporzionato al numero di sigarette fumate. La concentrazione di glucosio plasmatico può aumentare di 10 mg/dL (0.56 mmol/L) entro 10 minuti dal momento in cui si è fumato; tale effetto può protrarsi per un’ora. I fumatori tendono avere una concentrazione di glucosio più alta rispetto ai non fumatori, con un’alterata tolleranza glicemica. Il GH, inoltre, può aumentare anche 10 volte nella mezz’ora successiva al momento in cui si è fumata una sigaretta.

La valutazione degli esami diagnostici: sensibilità e specificità

Romolo Dorizzi1 & Marco Caputo2

1Laboratorio, UO Corelab-Laboratorio Unico di Area Vasta Romagna, Pievesestina di Cesena (FC)

2Laboratorio Chimica Clinica ed Ematologia, Ospedale G. Fracastoro, Azienda USL 20, Verona

Gli esami di laboratorio non dovrebbero esistere isolati dal contesto clinico. Infatti, nel momento in cui essi sono richiesti, il clinico ha già fatto una ipotesi provvisoria o ha approntato una lista di ipotesi diagnostiche basate sui sintomi e sui segni di ogni paziente.

Per valutare e interpretare un esame diagnostico è necessario conoscere come si comporta nel “malato” e nel “sano”. L’esame ideale dovrebbe essere anomalo nel 100% dei malati e non essere anomalo nel 100% dei soggetti sani. Questo ideale è raggiunto molto di rado; generalmente si verifica una sovrapposizione tra i due gruppi di soggetti. È pertanto utile ricordare alcune definizione di carattere epidemiologico che sono utili nel definire le capacità diagnostiche di un test.

- Sensibilità (percentuale dei risultati veri positivi) è la percentuale di risultati positivi di un esame nei pazienti affetti da una malattia. Un esame che è sempre anomalo (o positivo) nei pazienti malati ha una sensibilità del 100%.

- Specificità (percentuale dei risultati veri negativi) è la percentuale dei risultati negativi di un esame nei pazienti non affetti da malattia. Un esame che è sempre negativo nei soggetti sani ha una specificità del 100%.

- Percentuale di falsi negativi è la percentuale di risultati negativi nei pazienti affetti da malattia.

- Percentuale di falsi positivi è la percentuale di risultati positivi di un esame nei pazienti non affetti da una particolare malattia.

Incidenza e prevalenza di malattia

Romolo Dorizzi1 & Marco Caputo2

1Laboratorio, UO Corelab-Laboratorio Unico di Area Vasta Romagna, Pievesestina di Cesena (FC)

2Laboratorio Chimica Clinica ed Ematologia, Ospedale G. Fracastoro, Azienda USL 20, Verona

Prima di considerare l’effetto della prevalenza della malattia sui processi decisionali diagnostici, è necessario considerare il valore predittivo di un risultato positivo e di un risultato negativo. In pratica si esprime in tal modo la probabilità che un risultato anomalo sia interpretato dal clinico come proprio di un soggetto malato.

- Valore predittivo positivo di un test (VPP) esprime la probabilità che un soggetto con risultato positivo al test sia realmente affetto da malattia. Esso dipende dalla specificità e dalla prevalenza della malattia nella popolazione a cui viene applicato un test: tanto più alte sono la prevalenza e la specificità e tanto maggiore sarà il valore predittivo positivo di un test.

- Valore predittivo negativo di un test (VPN) esprime la probabilità che un soggetto con risultato negativo al test sia realmente sano. Esso dipende dalla sensibilità e dalla prevalenza della malattia nella popolazione a cui viene applicato un test: tanto più alta è la sensibilità e tanto minore è la prevalenza e tanto maggiore sarà il valore predittivo negativo di un test.

Statisticamente la probabilità di essere affetto da malattia o di non esserlo, a seconda che il test sia risultato positivo o negativo, è espressa dal teorema di Bayes. Tale teorema, pur non essendo particolarmente complicato da un punto di visto matematico, può essere applicato in modo intuitivo. Si consideri un test destinato a rivelare la presenza nel siero di anticorpi anti-HIV. Si assuma che questo test abbia una sensibilità del 100% (il test è quindi positivo nel 100% dei malati). Si assuma che il test abbia una specificità del 99.7% (il test, quindi, è negativo nel 99.7% dei soggetti sani). Si sa che la prevalenza della positività agli anticorpi anti-HIV è del 3 per mille nella popolazione generale. Qualora noi applicassimo il test a 1000 soggetti presi a caso, si avranno i seguenti risultati: 3 soggetti con positività del test, perché la prevalenza dei soggetti positivi è del 3 su mille (veri positivi), e 3 soggetti falsamente positivi, poiché, essendo la specificità del 99.7%, ci dovremo aspettare 3 positivi nei 997 soggetti sani del campione scelto a caso. In totale i soggetti positivi saranno 6, di cui solo 3 veramente positivi, con un VPP del 50%, nonostante i valori di sensibilità e di specificità siano particolarmente elevati. Per cercare di esplicitare l’influenza determinante della prevalenza della malattia nel campione di soggetti analizzato, immaginiamo ora le categorie a rischio per positività degli Ab anti-HIV. Tra gli omosessuali con partner occasionali la prevalenza di positività agli Ab anti-HIV è di circa il 10%. Questo significa che testando 1000 soggetti omosessuali promiscui avremo circa 103 pazienti con positività al test (100 dovuti alla prevalenza del 10% e 3 dovuti alla specificità del 99.7%), con un valore predittivo positivo del 97%. L’esempio consente di sottolineare come anche test considerati affidabili, per fornire un risultato significativo, devono essere effettuati dopo un attento ragionamento clinico.

L’intervallo di riferimento

Romolo Dorizzi1 & Marco Caputo2

1Laboratorio, UO Corelab-Laboratorio Unico di Area Vasta Romagna, Pievesestina di Cesena (FC)

2Laboratorio Chimica Clinica ed Ematologia, Ospedale G. Fracastoro, Azienda USL 20, Verona

I risultati degli esami di laboratorio sono accompagnati dai cosiddetti "intervalli di riferimento" (IR), che sono limiti con cui il clinico confronta il valore misurato nel singolo soggetto.

L’intervallo di riferimento è ottenuto misurando un particolare analita in un campione di individui estratto da una popolazione di riferimento. Gli individui di riferimento non sono necessariamente sani, ma semplicemente individui selezionati utilizzando criteri ben definiti. La valutazione della variabile nel campione di riferimento fornisce valori numerici denominati limiti di riferimento. Dal punto di vista pratico si devono selezionare in modo casuale gli individui dalla popolazione generale utilizzando dei criteri predefiniti che possono tenere conto, a seconda dei casi, di sesso, età, assunzione o meno di farmaci ed, eventualmente, dei risultati di accertamenti diagnostici di tipo generale.

Quando i risultati ottenuti nel gruppo di riferimento sono analizzati, essi si distribuiscono intorno a un valore centrale con una distribuzione che può essere simmetrica (spesso gaussiana) o più frequentemente asimmetrica (con coda a destra). Il metodo più utilizzato per scegliere l’intervallo di riferimento da questi risultati è quello di calcolare il 95% centrale della distribuzione. L’intervallo comprende cioè la popolazione compresa tra il percentile 2.5 e il 97.5. Per le variabili in cui si ha un eccesso di asimmetria con una coda importante a destra, la definizione dell’intervallo di riferimento prevede la trasformazione logaritmica dei risultati, al fine di rendere più simmetrica (gaussiana) la distribuzione dei valori.

Le caratteristiche analitiche di accuratezza e di precisione influenzano l’intervallo di riferimento: se viene usato un metodo non accurato, l’intervallo di riferimento rifletterà lo scostamento del metodo, mentre se un metodo non è preciso, l’intervallo di riferimento risulterà allargato (aumenterà la DS della distribuzione dei risultati).

L’intervallo andrebbe accompagnato sempre da un indice della variabilità campionaria della stima, il cosiddetto intervallo di confidenza, espresso di solito al 90% (vengono indicati i due valori entro cui vi è una probabilità del 90% che vi sia il limite di riferimento superiore ed inferiore).

Gli IR sono spesso utilizzati sia dal clinico che dal paziente come limiti in grado di discriminare il soggetto sano da quello malato. Si sta affermando, tuttavia, il concetto che, nonostante possano aiutare a individuare lo stato di benessere, siano spesso poco efficienti, o addirittura fuorvianti, per diagnosticare una condizione di malattia. È importante distinguere valori di riferimento cumulativi, valori di riferimento individuali e limiti decisionali (1,2).

Valori di riferimento cumulativi: il lavoro che il Committee on Reference Values della International Federation of Clinical Chemistry ha compiuto tra il 1978 ed il 1988 ha portato alla sistematizzazione della "Teoria degli Intervalli di riferimento", che ha codificato in modo preciso come calcolare gli IR (compresi in genere tra i percentili 2.5 e 97.5). Si tratta di un lavoro fondamentale dal punto di vista teorico, ma che presenta difficoltà di applicazione pressoché insormontabili nel mondo reale. Il clinico (l'endocrinologo in particolare) si trova quotidianamente di fronte alla dicotomia tra quanto è descritto in letteratura e quanto è riportato sui referti e si trova in difficoltà nell'interpretare risultati provenienti da laboratori distanti pochi chilometri che impiegano diverse nomenclature, IR e unità di misura. È fondamentale osservare come molti degli esami di laboratorio abbiano perduto la loro natura di essere diagnostici per acquisire quella di escludere, quando negativi, lo stato di malattia.

Valori di riferimento individuali: spesso l'IR calcolato nella popolazione generale è molto più ampio di quello proprio del singolo individuo, per esempio, per gli ormoni tiroidei e per il TSH (3). Variazioni nel tempo di tali ormoni possono essere clinicamente rilevanti, pur non superando i limiti di riferimento. Purtroppo, i valori di riferimento individuali non sono utilizzabili nella pratica clinica.

Limiti decisionali (o soglie decisionali, cut-off): si tratta di un concetto proposto nel 1968, che indica valori soglia, sopra o sotto ai quali il clinico prende una determinata decisione o tiene un determinato comportamento clinico. Si tratta di limiti empirici, che dipendono fortemente dal tipo di ormone e dal contesto in cui opera l'endocrinologo e sono più vicini alla diagnosi rispetto all'IR. Hanno finalità pratiche: a seconda che la concentrazione dell’analita misurata nel paziente sia sopra o sotto questi livelli, il clinico prende decisioni cliniche importanti (iniziare o sospendere una terapia, fare altre indagini diagnostiche, disporre il ricovero, programmare un intervento, dimettere il paziente). Richiedono una stretta collaborazione tra clinico e laboratorio: se il laboratorio cambia il metodo analitico senza comunicarlo tempestivamente al clinico, vi possono essere gravi conseguenze.

In Endocrinologia è particolarmente importante che nel referto sia indicato il metodo impiegato per determinare un ormone e che sia evitato l'uso di intervalli ricavati dalla letteratura. Queste considerazioni sono valide per tutti gli ormoni e i casi di calcitonina, tireoglobulina e testosterone sono solo esempi paradigmatici.

- Calcitonina (CT): il limite decisionale di 10 ng/L della CT risulta abbastanza valido con molti metodi nel maschio, mentre nella femmina produce numerosi errori di classificazione. Gli effetti di sesso, fumo (che aumenta i valori ottenuti con alcuni metodi) e massa corporea sulla concentrazione della CT dovrebbero essere, quindi, comunicati dal laboratorio (4).

- Tireoglobulina (Tg): Spencer et al. hanno misurato la Tg con 14 metodi diversi e gli anticorpi anti-Tg con 12 metodi diversi in 110 campioni e solo nel 10% dei 42 campioni studiati tutti i metodi hanno rilevato gli anticorpi anti-Tg (5,6). In molti campioni positivi per anticorpi anti-Tg tutti i metodi automatici in chemiluminescenza presentavano concentrazioni indosabili di Tg, suggerendo la presenza di interferenza, mentre tutti i metodi RIA fornivano risultati meno influenzati dalla presenza di anticorpi anti-Tg. Questo rappresenta uno dei casi più clamorosi in cui il clinico non può interpretare correttamente i risultati se non riceve da parte del laboratorio informazioni circa il metodo analitico usato sia per la Tg che per gli anticorpi anti-Tg.

- Testosterone (TT): anche se esiste la tecnologia per misurare in modo preciso, accurato e riproducibile il testosterone, la gascromatografia accoppiata a spettrometria di massa, i laboratori misurano testosterone totale e libero impiegando tecniche molto più inaccurate anche se semplici (7,8). L'intervallo nei maschi adulti è l'unico definito con una certa affidabilità: concentrazioni > 320 ng/dL sono compatibili con eugonadismo, mentre valori < 200 ng/dL con ipogonadismo. Gli intervalli nella donna adulta risentono non solo del metodo usato, ma anche della fase del ciclo mestruale, dell'età e del BMI. La determinazione del testosterone nel maschio in età avanzata e nel bambino è attendibile solo se l'analisi è eseguita in spettrometria di massa o in RIA dopo estrazione in cromatografia. In realtà, gli IR sono stati ottenuti in molti casi in popolazioni limitate e inadeguate (poche decine di soggetti di una fascia di età molto ampia, senza tener conto di ciclo mestruale, etnia e BMI). Nel 2010 è partito il programma HoST (Hormone Standardization), a cura del CDC di Atlanta e con la partecipazione tra gli altri della Endocrine Society e della American Association for Clinical Chemistry. L’obiettivo di questo progetto pluriennale (9) era quello di ottenere una standardizzazione effettiva dei metodi di dosaggio ormonale “critici”, in particolare quelli per testosterone totale nella donna e nel bambino e per l’estradiolo nell’uomo. I primi risultati sono oltremodo interessanti e lasciano sperare che i metodi immunometrici diretti possano essere affidabilmente utilizzati nella pratica clinica evitando il ricorso obbligato ai metodi estrattivi.

I clinici devono comunque sempre tenere ben presenti e conoscere le insidie presenti nella interpretazione degli IR usati nei referti degli ormoni.

Bibliografia

- Henny J. Interpretation of laboratory results: the Reference Intervals, a necessary evil? Clin Chem Lab Med 2007, 45: 939-41.

- Giavarina D. Gli intervalli di riferimento. RIMeL/IJLaM 2006, 2: 50-6.

- Andersen S, Bruun NH, Pedersen KM, Laurberg P. Biologic variation is important for interpretation of thyroid function tests. Thyroid 2003, 13: 1069-78.

- D'Herbomez M, Caron P, Bauters C, et al. Reference range of serum calcitonin levels in humans: influence of calcitonin assays, sex, age, and cigarette smoking. Eur J Endocrinol 2007, 157: 749-55.

- Spencer CA, Bergoglio LM, Kazarosyan M, et al. Clinical impact of thyroglobulin (Tg) and Tg autoantibody method differences on the management of patients with differentiated thyroid carcinomas. J Clin Endocrinol Metab 2005, 90: 5566-75.

- Schlumberger M, Hitzel A, Toubert ME, et al. Comparison of seven serum thyroglobulin assays in the follow-up of papillary and follicular thyroid cancer patients. J Clin Endocrinol Metab 2007, 92: 2487-95.

- Rosner W, Auchus RJ, Azziz R, et al. Utility, limitations, and pitfalls in measuring testosterone: an Endocrine Society position statement. J Clin Endocrinol Metab 2007, 92: 405-13.

- Fritz KS, McKean AJS, Nelson JC, Wilcox RB. Analog-based free testosterone test results linked to total testosterone concentrations, not free testosterone concentrations. Clin Chem 2008, 54: 512-6.

- Centers for Disease Control and Prevention: Laboratory Quality Assurance and Standardization Programs. (consultato 22/03/2015)

Unità di misura

Romolo Dorizzi1 & Marco Caputo2

1Laboratorio, UO Corelab-Laboratorio Unico di Area Vasta Romagna, Pievesestina di Cesena (FC)

2Laboratorio Chimica Clinica ed Ematologia, Ospedale G. Fracastoro, Azienda USL 20, Verona

Ogni misurazione, per avere un significato, deve essere espressa da un’unità di misura e da un numero. L’unità di misura indica la dimensione (massa, volume o concentrazione), mentre il numero indica quante unità sono presenti nel campione. Nel corso dell’evoluzione della medicina di laboratorio sono entrate in uso nei diversi paesi modalità diverse per l’espressione della concentrazione dei costituenti di interesse medico. L’applicazione delle unità SI nel laboratorio clinico, introdotta per ovviare a questo problema, è risultata particolarmente complessa, poiché realizza il punto d’incontro di ambiti di conoscenza diversi come chimica, biochimica, fisica, tecnologia e medicina. Nel laboratorio clinico sono di solito misurate le concentrazioni di un costituente in un fluido biologico e tradizionalmente queste erano riportate in termini di massa per unità di volume. Poiché non vi erano regole o una logica precise, veniva usata una grande varietà di unità per refertare i valori di concentrazione, impiegando di solito le concentrazioni per 100 mL (o decilitro). A partire dagli anni ‘60 si è cominciato a proporre che le determinazioni fossero espresse in termini molecolari per litro invece che in termini di massa per 100 mL (o decilitro). Le principali motivazioni erano:

- i processi metabolici che avvengono nel nostro organismo seguono leggi chimiche che si svolgono in termini di reazione di un determinato numero di atomi, molecole o ioni (e non di peso);

- la mole è appropriata per molte delle tecniche analitiche classiche (spettrofotometria, fluorimetria, ecc.);

- la concentrazione dei calibratori è definita senza ambiguità, indipendentemente dalla forma chimica del materiale usato. Per esempio il glucosio può essere anidro o monoidrato: mentre 10 mmol/L di glucosio contengono la stessa quantità di glucosio nelle due forme, 180 mg/dL contengono quantità diverse;

- l’adozione delle unità SI nei paesi scandinavi e nei paesi anglosassoni (con la rilevante eccezione degli Stati Uniti) è andata avanti piuttosto rapidamente, mentre in altri paesi i referti continuano a contenere le unità convenzionali o le due unità (la scelta più frequente ma meno corretta).

Appropriatezza degli esami di laboratorio

Romolo Dorizzi1 & Marco Caputo2

1Laboratorio, UO Corelab-Laboratorio Unico di Area Vasta Romagna, Pievesestina di Cesena (FC)

2Laboratorio Chimica Clinica ed Ematologia, Ospedale G. Fracastoro, Azienda USL 20, Verona

Si sta estendendo anche alla Medicina di Laboratorio la classica definizione della Evidence Based Medicine (EBM) "l’esplicito e prudente impiego delle migliori prove di efficacia nel prendere decisioni circa la cura di un singolo paziente", tenendo conto delle problematiche particolari legate alle intrinseche peculiarità di questa disciplina. L’EBM può insegnarci a tenere conto dei limiti che possono influenzare i risultati, ma l’applicabilità dei principi dell’EBM nella diagnostica di laboratorio è ostacolata da aspetti come la frequente mancanza di un "gold standard" assoluto con cui confrontare i nuovi esami e la grande diversità tra i valori numerici forniti da metodi diversi per la misurazione di uno stesso analita (basti pensare al GH).

Come valutare la letteratura relativa agli esami diagnostici di laboratorio

Secondo Sackett l’EBM deve aiutare a rispondere a 3 domande:

- le prove di accuratezza di un esame diagnostico sono valide?

- questo esame è in grado di distinguere in modo accurato i pazienti con una determinata malattia da quelli che non la presentano?

- posso usare questo esame nel particolare paziente che ho di fronte in questo momento?

Come valutare la capacità di un esame di diagnosticare una malattia: Sensibilità, Specificità e Quoziente di probabilità

L’EBM si concentra sui classici concetti di sensibilità e specificità come mezzo per calcolare il Quoziente di Probabilità (Likelihood Ratio: LR), lo strumento che consente di calcolare come la probabilità di una diagnosi sia modificata dal risultato di un esame (ovvero, come si calcola la probabilità post-test a partire dalla probabilità pre-test). Concettualmente l’LR positivo e negativo indicano il rapporto (quoziente) tra la probabilità di trovare un particolare risultato (rispettivamente positivo e negativo) in un paziente affetto da una malattia rispetto a quello di trovare lo stesso risultato in un soggetto che non è affetto dalla stessa malattia. Questo è importante dal punto di vista pratico, perché consente di valutare se un esame diagnostico può essere utile alla diagnosi e quale esame è da preferire quando ve ne siano numerosi disponibili.

L’LR consente anche di tenere conto di come la concentrazione più o meno alta del risultato dal punto di vista statistico possa influenzare la probabilità di un risultato. Mentre impiegando i concetti di sensibilità e specificità il risultato può essere solo positivo o negativo, l’LR ci consente di attribuire un diverso peso a seconda del risultato numerico ottenuto. Purtroppo fino ad oggi sono stati calcolati gli LR a concentrazioni diverse solo per pochi esami diagnostici e per pochi contesti clinici. Sono stati proposti dei criteri per classificare l’utilità degli esami diagnostici in relazione al loro LR che, anche se grossolani, possono risultare molto utili nella pratica:

- LR positivi > 10 e negativi < 0.1 modificano in modo spesso conclusivo la probabilità di malattia;

- LR positivi 5 ÷ 10 e negativi 0.1 ÷ 0.2 modificano in modo discreto la probabilità di malattia;

- LR positivi 2 ÷ 5 e negativi 0.2 ÷ 0.5 modificano in modo limitato (solo raramente importante) la probabilità di malattia;

- LR positivi 1 ÷ 2 e negativi 0.5 ÷ 1 modificano scarsamente la probabilità di malattia e solo di rado sono importanti.

Uno strumento ulteriore per valutare un esame diagnostico è l’NND (Number Needed to Diagnose = numero di test necessari per ottenere una diagnosi positiva), che si calcola conoscendo la sensibilità e specificità di un esame. L’NND è il meno conosciuto ed usato strumento dell’EBM, probabilmente a causa della non immediatezza del suo calcolo:

NND = (1/sensibilità)-(1-specificità)

L’NND potrebbe tuttavia risultare utile nella pratica per confrontare il rapporto costo/beneficio degli esami di laboratorio, soprattutto nei casi in cui in un determinato contesto clinico possono essere impiegati più esami.

Uno degli aspetti più rilevanti della EBM è l’approccio pratico che introduce nell’impiego dei risultati di laboratorio per la gestione del singolo paziente. Due esempi sono gli acronimi SnNout e SpPin e il Nomogramma di Fagan. I due acronimi rendono più facile ricordare qual’è l’impiego ottimale di un esame diagnostico molto sensibile o molto specifico:

- SnNout è un acronimo inglese che deriva da ‘When a test has a very high Sensitivity, a Negative result rules out the diagnosis’ (quando un esame ha una sensibilità molto elevata, un risultato negativo esclude virtualmente la diagnosi);

- SpPin deriva invece da ‘When a test has a very high Specificity, a Positive result rules in the diagnosis’ (quando un esame ha una specificità molto elevata, un risultato positivo virtualmente conferma la diagnosi).

In questa maniera è possibile assegnare in modo "automatico" un significato clinico concreto ad un esame molto sensibile o molto specifico.

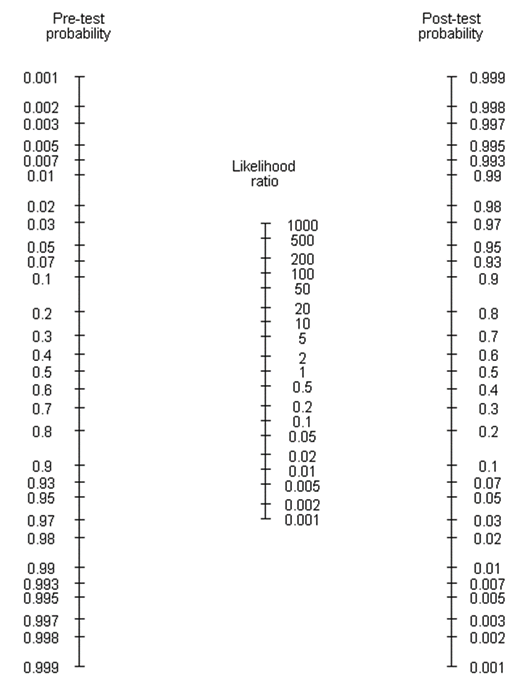

Il Nomogramma di Fagan consente di semplificare la conversione della probabilità pre -test in quella post-test. Il nomogramma si usa (figura) ancorando una linea retta in corrispondenza della probabilità pre-test indicata sull’asse di sinistra e ruotandola finché raggiunge l’LR relativo all’esame che si sta considerando, indicato nell’asse al centro. È sufficiente proseguire la retta e si troverà sull’asse di destra la probabilità post-test. Il nomogramma può essere tenuto nella tasca del clinico e del laboratorista per un impiego immediato.

-test in quella post-test. Il nomogramma si usa (figura) ancorando una linea retta in corrispondenza della probabilità pre-test indicata sull’asse di sinistra e ruotandola finché raggiunge l’LR relativo all’esame che si sta considerando, indicato nell’asse al centro. È sufficiente proseguire la retta e si troverà sull’asse di destra la probabilità post-test. Il nomogramma può essere tenuto nella tasca del clinico e del laboratorista per un impiego immediato.

I vantaggi dell’impiego dei LR e del nomogramma di Fagan sono quindi numerosi:

- sono più comprensibili e più facili da usare rispetto a sensibilità e specificità;

- possono essere calcolati a livelli diversi di risultato;

- possono essere usati in modo sequenziale, in modo che la probabilità post-test che si ottiene da un esame costituisca la probabilità pre-test per il successivo;

- consentono di embricare laboratorio e clinica in modo efficace;

- forniscono gli strumenti per gli audit clinici, perchè consentono di valutare l’efficacia diagnostica degli esami richiesti dal clinico ed eseguiti dal laboratorio.

Il clinico, di fronte ad un esame, deve quindi chiedersi se questo sarà in grado di aiutarlo a risolvere un problema diagnostico, clinico o terapeutico e, per fare questo, dovrà considerare sia l’esame stesso sia il contesto clinico in cui esso sarà usato. Il clinico, per esempio, dovrebbe conoscere:

- se l’esame è disponibile, accurato, riproducibile e accessibile nel contesto in cui opera;

- qual è la probabilità pre-test;

- se la probabilità post-test che si ottiene è in grado di modificare la gestione del paziente;

- se le conseguenze mediche di un particolare esame sono accettabili per il paziente;

- se il consumo di risorse sanitarie ad esso connesse ed il rapporto costo-benefici sono accettabili.

Il ragionamento probabilistico

Marco Caputo

Dipartimento dei Servizi di Diagnosi e Cura, Ospedale G. Fracastoro, Azienda ULSS20, Verona

(aggiornato al 18 ottobre 2016)

La parte preponderante della vita professionale di un medico, qualsiasi sia la sua specializzazione, è dedicata alla raccolta e alla valutazione del dato clinico. Le decisioni che guideranno ogni strategia diagnostica e ogni scelta terapeutica dipendono in modo assoluto dalla capacità di esercitare al meglio questa attività. Si è discusso a lungo se questa capacità sia frutto dell’applicazione di un rigoroso metodo scientifico o non debba anche necessariamente avvalersi di una componente “artistica”, svincolata da dati oggettivi e valutazioni quantitative e legata invece a un’ineliminabile dote di intuito, quello che una volta veniva chiamato “occhio clinico”. Si tratta di un lavoro complicato, che solo raramente può giovarsi di certezze incontrovertibili; il ricorso a esami diagnostici è praticamente inevitabile, continuo e -naturalmente- non privo di rischi. Alcuni di questi rischi sono evidenti; altri sono più sottili ma ugualmente onerosi, come la componente di stress, paura e insicurezza che il paziente sperimenta nel suo viaggio all’interno dell’universo sanitario e che non può non ribaltare sul proprio Curante. Qui interviene un’ulteriore esigenza: quella di saper comunicare al paziente l’esito della propria indagine, in funzione delle scelte del percorso assistenziale, scelte che oggi devono essere necessariamente condivise.

Ci sono poi i “costi” legati all’acquisizione delle informazioni: costi diretti delle tecnologie utilizzate e costi indiretti dovuti alle ricadute delle decisioni assunte sulla base dei risultati ottenuti. Le evidenze ci dicono senza margini di incertezza che la variabilità di questo processo è elevatissima, non solo in paesi e organizzazioni sanitarie lontane tra loro, ma spesso anche nello stesso ambito territoriale. Gli scenari che già oggi vediamo concretizzarsi attestano che la classe medica ha sempre meno autorevolezza nel guidare questi processi complessi, spesso per oggettivi vincoli esterni, ma talvolta anche per la propria incapacità a orientarsi in un universo sempre più complesso.

L’Institute of Medicine (IOM), nell’ultimo contributo aggiunto alla fine dello scorso 2015 alla serie dedicata al “Quality Chasm”, raccomanda fortemente di curare la formazione continua e le competenze in ambito di ragionamento clinico di tutte le professioni sanitarie, come lo strumento più efficace per migliorare le prestazioni diagnostiche e di conseguenza contribuire a ridurre le conseguenze degli errori legati alle prestazioni assistenziali.

Il teorema di Bayes

Il ragionamento clinico si fonda largamente sull’inferenza bayesiana. Al reverendo Thomas Bayes (1702-1761) si deve la formulazione dell’equazione che spiega come dovrebbe ragionare la mente del medico di fronte al quesito clinico e ai test che di volta in volta vengono pensati e attuati per ridurre il margine di incertezza sull’attribuzione di determinati segni e sintomi a una determinata patologia. Ancora oggi il dilemma che grava sui medici e i loro pazienti può rappresentare un ostacolo insormontabile.

Per cercare di rendere più agevole la comprensione del modo in cui la mente umana affronta questi temi, un contributo comparso su Science offre una chiave di lettura più abbordabile. Gli autori partono da quanto le scienze psicologiche ci hanno insegnato sull’errore diagnostico e di quanto facilmente le impressioni immediate portino a sbagliare anche grossolanamente, a causa dell’approccio euristico e dei bias cognitivi che ci inducono a invitanti scorciatoie mentali, a scapito della riflessione mediata dal pacato ma lungo e a volte noioso ragionamento statistico. Ma a questa via obbligata si può sfuggire. Basta elaborare il problema in “formati”, per i quali la mente è più veloce a elaborare risposte.

Di fronte al paziente ci si trova a operare dovendo valutare un “evento singolo”, per es. una probabilità di malattia dello 0.1%. Difficile da cogliere per la nostra mente, ma se si trasforma il dato in frequenza relativa a una popolazione di riferimento, ad esempio una frequenza di 1 su 1000, è possibile facilitare la corretta comprensione del rischio e dell’inevitabile incertezza connessa al processo decisionale medico. Il rischio di errore rimane se il procedimento viene applicato ad una popolazione di riferimento non appropriata. È quindi indispensabile selezionare la giusta popolazione, come pure la prevalenza e gli esiti di malattia all’interno di quella popolazione di riferimento: senza questi elementi è impossibile prevedere realisticamente gli eventi e di conseguenza elaborare la corretta strategia.

Gli elementi della equazione di Bayes:

- Sensibilità. Immaginiamo di dovere utilizzare un test diagnostico in una popolazione di 100 pazienti, dei quali 30 siano affetti da una patologia. L’esame ideale - quello che riconosce tutti e 30 i malati e viene sempre negativo nei restanti 70 - non esiste. Nel nostro caso il test identifica correttamente 24 pazienti su 30. 24/30 = 0.80 = 80%. La sensibilità è la qualità di un test di riconoscere i colpiti da malattia. Un test “sensibile”, applicato in routine, dà forza a un risultato negativo, in altri termini aiuta a escludere la diagnosi che sospettavamo. Può essere utile l’acronimo memonico SNOUT: “high Sensitivity and Negative results rule OUT the diagnosis”.

- Specificità. Il nostro test risulta negativo in 56 delle 70 persone sane nella nostra popolazione. 56/70 = 0.80 = 80%. La specificità è la qualità di un test di riconoscere correttamente tutti gli esenti da quella malattia. Un test “specifico”, applicato in routine, dà forza a un risultato positivo, in altri termini accresce la probabilità che la malattia sia presente. Può essere utile l’acronimo mnemonico SPIN: “high Specificity and Positive results rule IN the diagnosis”.

- Prevalenza o Probabilità pre-test. È la probabilità della presenza di malattia nella nostra popolazione prima di eseguire il test.

L’equazione che esprime il teorema è la seguente:

Probabilità = (prevalenza*sensibilità)/[(prevalenza*sensibilità)+(1+prevalenza)*(1-specificità)]

Questa relazione può essere espressa in modo semplificato ricorrendo al concetto di Quoziente di Probabilità (Likelihood Ratio, LR), che non è altro che la probabilità che si abbia un determinato risultato nel soggetto malato, diviso la probabilità di ottenere lo stesso risultato in un soggetto sano. Questo ci permette di semplificare l’espressione precedente in questo modo:

LR = sensibilità/(1-specificità)

- Se LR = 1, il nostro test è perfettamente inutile ai fini dell’informazione clinica; equivale a lanciare una moneta.

- Quanto maggiore di 1 sarà LR, tanto maggiore la probabilità che la malattia che cerchiamo sia presente (LR+ per risultati positivi).

- Più LR è inferiore a 1, tanto diminuisce la probabilità di presenza di malattia (LR- per risultati negativi).

Abbiamo ora tutti gli elementi per valutare il nostro esempio e ricavarne elementi per un ragionamento clinico. Disponiamo di un esame con una sensibilità e una specificità pari a 80%, da applicare su una popolazione in cui la prevalenza di malattia è pari a 30%. In queste condizioni, il Valore Predittivo di un risultato positivo (VPP) sarà pari a 24/38 (rapporto tra i malati correttamente identificati come positivi che erano 24/30 e tutti i risultati positivi, cioè i 24 + i 12 di 70, che erano positivi pur in assenza di malattia). 24/38 = 63%.

Ma cosa succederebbe se la prevalenza di malattia nella nostra popolazione invece del 30% fosse più bassa, diciamo il 10%? Allora il VPP sarebbe 8/26 (cioè l’80% di 10, diviso 8 + 18), cioè 31% scarso. E se la prevalenza fosse ancora più bassa? Allora VPP = 1/21 = 5%.

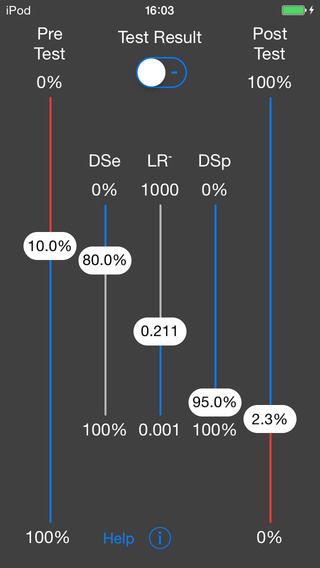

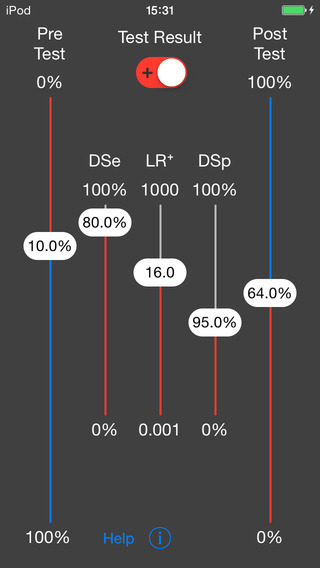

Esiste da molti anni uno strumento relativamente semplice per calcolare i risultati delle relazioni bayesiane applicate al singolo concreto caso clinico. Si tratta del nomogramma di Fagan, un calcolatore grafico applicabile alla routine clinica (fig 1).

Figura 1: nomogramma di Fagan

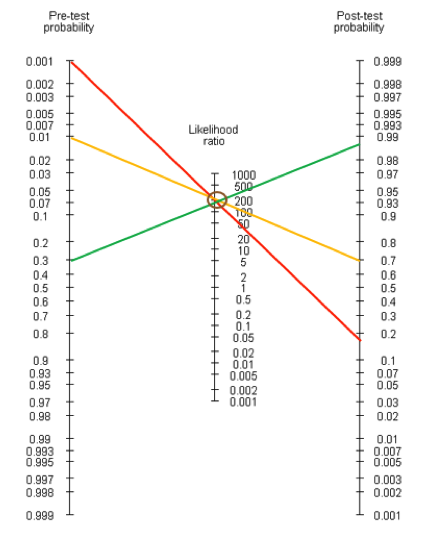

Se è nota la prevalenza di malattia (colonna di sinistra) e il LR (colonna al centro), è possibile ricavare automaticamente la probabilità post-test (colonna di destra) unendo semplicemente i 2 punti precedenti. A titolo di esempio viene riportato il caso del dosaggio del TSH nell’ipotiroidismo (fig 2).

Figura 2: nomogramma di Fagan applicato al dosaggio di TSH nell’ipotiroidismo. La prevalenza di ipotiroidismo in uno screening nella popolazione generale è 0.1% (linea rossa), nell’ambulatorio di medicina generale è 1% (linea gialla), in un ambulatorio di endocrinologia è 30% (linea verde).

L’esame è dotato di prestazioni diagnostiche eccellenti assolute, in termini di sensibilità, specificità e LR. Tuttavia, come si può vedere, il valore informativo del risultato dipende in modo fondamentale dalla prevalenza della malattia, che è molto diversa a seconda del contesto in cui ci si trova.

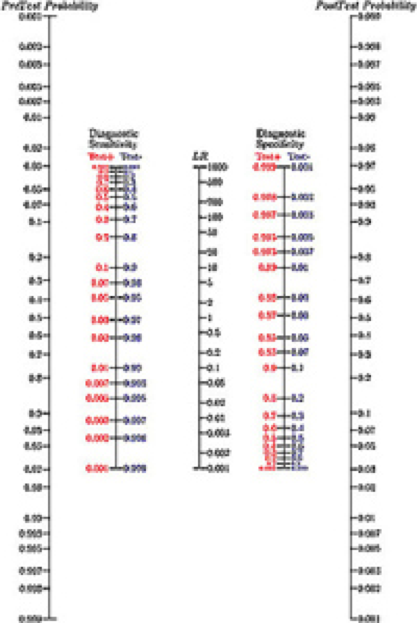

Per cercare di rendere ancora più pratico l’utilizzo del nomogramma, è stata creata una variante (fig 3), definita “a 2 fasi” (2-step). Al formato originale sono state aggiunte due colonne, da impiegare per calcolare LR qualora non fosse noto.

Figura 3: nomogramma di Fagan 2-step

In pratica, dopo aver ottenuto sensibilità e specificità del test (dalla letteratura o dal produttore) e il risultato dell’esame (positivo o negativo), si collegano gli assi di sensibilità e specificità e si legge il corrispondente LR sull’asse centrale. Da qui si procede come con il nomogramma standard, unendo la prevalenza sulla colonna di sinistra con l’LR sulla colonna centrale e prolungando fino a incontrare la colonna di destra.

Infine, per cercare di rendere questo strumento ancora più pratico, sono da poco disponibili delle versioni app per smartphone (fig 4).

Figura 4: nomogramma di Fagan su App

In conclusione, è destinata a proseguire la lotta contro l’incertezza che condiziona il comportamento delle professioni sanitarie nel momento di applicare il risultato di un esame alla diagnosi o alla stratificazione del rischio del proprio paziente. Tuttavia, abbiamo la possibilità di utilizzare meglio le informazioni che ci arrivano da una tecnologia sempre più complessa e sofisticata. Al momento di entrare nell’era della Medicina di Precisione, in cui il nostro bagaglio di dati e conoscenze non potrà essere più interpretato come medie tra gruppi, ma andrà applicato al singolo individuo, non avremo più certezze da consegnare su ciò che è bene e ciò che è male fare per il nostro paziente, ma dovremo essere capaci di far assumere a lui le decisioni importanti per la sua salute. Per questo obiettivo, nobile ma complicatissimo da perseguire, abbiamo ancora bisogno di strumenti affidabili e pratici da utilizzare nel lavoro quotidiano, come quelli derivati dall’intuizione del reverendo Thomas Bayes.

Per approfondire

- Balogh EP, Miller BT, Ball JR, ed. Improving diagnosis in health care. Committee on Diagnostic Error in Health Care; Board on Health Care Services; Institute of Medicine; National Academies of Sciences, Engineering, and Medicine. Washington (DC): The National Academies Press; 2015.

- Operskalski JT, Barbey AK. Risk literacy in medical decision-making: how can we better represent the statistical structure of risk? Science 2016, 352: 413–4.

- Henriquez RR, Korpi-Steiner R. Bayesian inference dilemma in clinical decision making: a need for user-friendly probabilistic reasoning tools. Clin Chem 2016, 62: 1285-6.

- Caraguel CGB, Vanderstichel R. The two-step Fagan’s nomogram: ad hoc intepretation of a diagnostic test result without calculation. Evid Based Med 2013, 18: 125-8.

- Nomographs with Python, Version 0.2.2. 2010. (accesso 14/10/2016).

- Università di Adelaide. Nomogramma di Fagan a 2-fasi (scaricabile qui).

Introduzione alle tecniche di laboratorio

Romolo Dorizzi1 & Marco Caputo2

1Laboratorio, UO Corelab-Laboratorio Unico di Area Vasta Romagna, Pievesestina di Cesena (FC)

2Laboratorio Chimica Clinica ed Ematologia, Ospedale G. Fracastoro, Azienda USL 20, Verona

Molte determinazioni di laboratorio si basano su misure di energia radiante assorbita, trasmessa, emessa, diffusa, riflessa. L’uomo è capace di percepire solo una piccola frazione (luce “visibile”: da 380 a 750 nm) dell’estesa gamma di lunghezze d’onda presenti nell’energia radiante dell’universo. Gli strumenti analitici sono in grado di estendere la rilevazione a lunghezze d’onda inferiori (luce “ultravioletta”, UV) o superiori (luce “infrarossa”, IR) e questa proprietà è stata sfruttata per scopi analitici.

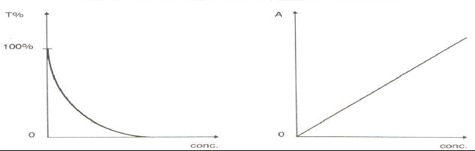

Il termine fotometria si riferisce alla misura della luce. Il termine spettrofotometria si riferisce alla misura dell’intensità di luce a una lunghezza d’onda selezionata. Quest’ultima è la metodologia utilizzata in Chimica Clinica per un ampio ventaglio di determinazioni qualitative e quantitative. Il principio sfrutta le proprietà di assorbimento della luce possedute dalla sostanza da analizzare o da un suo diretto derivato. L’intensità di una luce che attraversi una soluzione in cui è disciolta una sostanza assorbente (detta “cromogeno”) diminuisce in maniera proporzionale alla frazione assorbita. La rilevazione e la misura di questa frazione assorbita può essere usata per stabilire una relazione tra luce trasmessa (o assorbita) e la concentrazione della sostanza da analizzare. La cosiddetta legge di Lambert-Beer, che stabilisce la proporzionalità diretta della concentrazione di una sostanza dalla quantità di luce assorbita e la proporzionalità inversa rispetto al logaritmo della luce trasmessa è il principio su cui si è sviluppata tutta la tecnologia che adotta la spettrofotometria come principio operativo, dai più semplici strumenti monocromatici ai più complessi e potenti analizzatori in dotazione alle grandi piattaforme automatizzate.

Figura 1: rappresentazione grafica della legge di Lambert-Beer. A sinistra relazione inversa fra concentrazione della sostanza in esame nel liquido biologico e luce trasmessa; a destra proporzione diretta tra concentrazione e luce assorbita.

La spettrometria in assorbimento atomico è una tecnica usata per la determinazione di oligo-elementi (rame, zinco, alluminio, piombo, litio, magnesio, ecc) in soluzione. In pratica, il metallo da ricercare viene ridotto da una fiamma o da una fonte di calore allo stato gassoso e in forma energeticamente neutra. In queste condizioni, l’atomo assorbe solo radiazioni con ampiezza di banda molto stretta, come quella emessa dalla luce di una lampada (detta “a catodo vuoto”) rivestita dallo stesso metallo che si vuole determinare. Quando la luce attraversa la camera di misurazione, subisce una netta diminuzione di intensità in presenza della sostanza corrispondente: a questo fenomeno si deve il nome di assorbimento atomico. Ci sono lampade selettive (un solo metallo) e altre composite (rivestite da più metalli) adatte alla determinazione di più analiti. Esistono strumentazioni evolute che hanno sostituito la fiamma con barre di carbonio (“fornetto di grafite”).

Si intende per fluorescenza la condizione in cui una molecola assorbe luce a una determinata lunghezza d’onda e la riemette a una lunghezza d’onda maggiore. Un atomo o molecola che possegga questa proprietà è chiamato fluoroforo. La fluorimetria è la misura della luce fluorescente emessa, e su questo principio si basa un’ampia varietà di analisi quantitative, molto accurate e sensibili, condotte attraverso l’uso di una vasta gamma di diverse strumentazioni. Esistono fluorimetri e spettrofluorimetri di varie tipologie e dimensioni. I fluorimetri a risoluzione temporale (time-resolved) ovviano a uno dei principali difetti della fluorescenza e cioè la rapidità del decadimento del segnale attraverso le proprietà di fluorofori a lunga decadenza (1,2). Esistono sistemi basati su questo principio (o una delle sue numerose varianti), per misurare gli ormoni di principale utilizzo, dalla tiroide al PTH al cortisolo. Il sistema DELFIA della Perkin Elmer è l’esempio più noto.

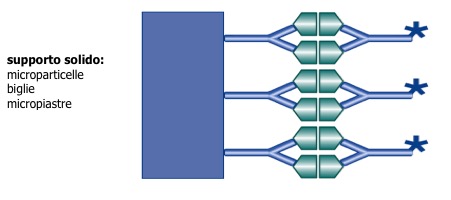

La citometria a flusso è una particolare applicazione della fluorimetria, dedicata all’analisi di cellule e altre particelle biologiche (3,4). I citofluorimetri sono in grado di analizzare contemporaneamente parametri multipli, quali le dimensioni cellulari, la presenza e quantità di granuli, il contenuto in DNA e RNA, i rapporti nucleotidici {(A + T)/(G + C)}, la struttura cromatinica, i recettori cellulari e altro ancora. Le applicazioni della citofluorimetria sono oggi vastissime, dall’immunologia all’ematologia, dall’oncologia alla microbiologia e alla genetica, fino alla possibile applicazione a immuno-dosaggi anche di interesse endocrinologico (per esempio il riconoscimento attraverso anticorpi monoclonali di cellule e molecole da ago-aspirati di lesioni ghiandolari), grazie all’impiego dei test basati su particelle e a fluorocromi molto potenti e a emissione prolungata come la ficoeritrina.

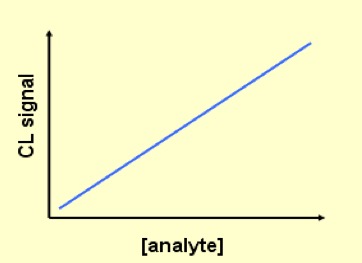

La chemiluminescenza è l’emissione di luce che si ha quando un elettrone ritorna da un livello energetico eccitato a un livello energetico inferiore. Se la sorgente di eccitazione non è una sostanza chimica (es. luminolo, isoluminolo, esteri di acridinio, luciferina) ma un componente di sistemi biologici si parla di bioluminescenza. I metodi in chemiluminescenza hanno trovato vastissima diffusione nei laboratori di immunometria e sono stati ampiamente applicati per il dosaggio in automazione di moltissimi ormoni, ma anche nei sistemi di rilevazione di sonde di DNA per studi di biologia molecolare. L’elettro-chemiluminescenza si diversifica dalla chemiluminescenza per il fatto che i reattivi che producono la reazione chemiluminescente sono generati elettrochimicamente sulla superficie di un elettrodo a partire da un precursore stabile (5). Il più utilizzato di questi marcatori è un chelato del Rutenio Ru2+. È un reagente molto stabile e relativamente piccolo ed è stato utilizzato per marcare apteni e molecole più grandi come oligonucleotidi e proteine. I principali vantaggi di questo metodo sono una maggiore stabilità dei reagenti e una loro preparazione semplificata e una maggiore sensibilità, con limiti di rilevazione da 200 fmol/L e un range dinamico che arriva a coprire fino a sei ordini di grandezza. La principale limitazione dei test in chemiluminescenza risiede proprio nell’estrema sensibilità analitica, che impone di operare controlli stringenti sull’integrità dei reagenti e le parti del sistema.

La misura della luce diffusa è invece realizzata attraverso due metodi e viene largamente impiegata nella quantificazione delle siero-proteine. La turbidimetria consiste nel misurare la diminuzione dell’intensità di un raggio incidente che attraversa un contenitore di particelle in soluzione. È un principio che si applica con estrema facilità agli spettrofotometri e alle piattaforme di grande automazione, anche grazie alla stabilità e al potere di risoluzione degli strumenti guidati dai moderni microprocessori. Si parla di nefelometria quando la rilevazione dell’energia luminosa diffusa o riflessa è indirizzata verso un rilevatore che non si trova sulla traiettoria diretta del raggio di luce trasmessa. Di solito i comuni nefelometri misurano la luce diffusa ad angolo retto rispetto alla luce incidente. La scelta tra nefelometria e turbidimetria dipende dalle applicazioni e dalla strumentazione disponibile. La nefelometria offre qualche vantaggio in termini di sensibilità a basse concentrazioni, ma è meno consolidabile rispetto alla turbidimetria sulle grandi piattaforme automatizzate (6).

Il termine cromatografia si riferisce alla separazione dei componenti di una miscela, in base alla loro differente distribuzione tra una fase mobile e una fase fissa o stazionaria. I componenti maggiormente presenti nella fase stazionaria sono trattenuti e si spostano più lentamente nel sistema. La tecnica è stata messa a punto all’inizio del secolo scorso per separare dei pigmenti vegetali che si evidenziavano come bande colorate (“croma-”, greco per “colore”) su una colonnina di carbonato di calcio. Le separazioni cromatografiche sono classificate in base ai meccanismi fisici o chimici utilizzati per separare i componenti: a scambio ionico, partizione, affinità, assorbimento, esclusione sterica. Tra i vari supporti che si possono utilizzare, la cromatografia su colonna è la più largamente diffusa nei laboratori clinici, nelle due varietà di gascromatografia (GC) e cromatografia liquida (LC), a seconda che la fase mobile sia gassosa o liquida (7,8). Con questa tecnica si possono misurare tutti gli ormoni steroidei, i metaboliti di metanefrine e serotonina, farmaci vari. Se la fase stazionaria in LC è costituita da particelle di piccolo diametro, si parla di “cromatografia liquida a elevate prestazioni”, o HPLC.

Il cromatografo liquido o gassoso può essere connesso a uno spettrometro di massa (MS), dando origine a una potente tecnica analitica sempre più utilizzata anche negli studi endocrinologici, la cromatografia liquida/spettrometria di massa (LC-MS) e la gascromatografia/spettrometria di massa (GC-MS). Il termine “spettrometria di massa” è in realtà un misnomero: questi strumenti non misurano la massa molecolare ma il rapporto massa/carica. Bisogna aver presente questo concetto per poter apprezzare a pieno l’architettura e la funzionalità strumentale e, fatto ancora più importante, l’interpretazione dei risultati.

La doppia spettrometria di massa, MS/MS o Tandem-MS, quando utilizzata in sinergia con l’elevatissima selettività di una GC o LC (GC/Tandem-MS, LC/Tandem-MS), accoppia la bassa incidenza di interferenze al basso costo dei reagenti e alla possibilità di analizzare molti campioni in poco tempo; non sorprende che questa tecnologia si stia rapidamente diffondendo nei laboratori clinici e sia diventata tra l’altro gold standard per la quantificazione di molte sostanze di interesse endocrinologico (per esempio gli steroidi tutti, da cortisolo a testosterone, ma anche le frazioni libere degli ormoni tiroidei, la vitamina D, ecc). I limiti alla sua diffusione universale restano al momento l’elevato costo dell’hardware e la necessità di un accurato know-how da parte di personale dedicato (9-11).

Il dosaggio “ideale” per la misurazione degli ormoni dovrebbe:

- riflettere l'attività biologica dell'ormone;

- essere abbastanza sensibile da richiedere volumi contenuti di campione;

- consentire l'automazione e una produttività molto elevata;

- essere molto accurato e riproducibile.

Gli ormoni sono misurati nella pratica corrente dei laboratori clinici con metodi immuno-metrici, radio-immunologici, immuno-radiometrici, immuno-enzimatici e in chemi-luminescenza. Tutte queste tecnologie derivano da quella radio-immunologica (RIA), un metodo analitico che unisce la specificità di una reazione immunologica (con formazione di un complesso antigene-anticorpo) con la sensibilità di un metodo radio-chimico, dato che è utilizzato un radio-isotopo.

La tecnica RIA, descritta per la prima volta nel 1959, ha soppiantato rapidamente i bio-assay, che fino a quel momento erano gli unici metodi in grado di misurare gli ormoni: per esempio, l’insulina era misurata in vivo valutando l’ipoglicemia indotta nei ratti ipofisectomizzati, surrenectomizzati e resi diabetici con alloxana e in vitro valutando la captazione di glucosio da parte del cuscinetto di tessuto adiposo epididimale di ratto. I metodi RIA classici sono basati su tre elementi:

- una molecola di ormone, che funziona da antigene, a cui è legato un tracciante radioattivo (in passato Trizio, oggi di solito 125Iodio), che emette radiazioni misurabili con un contatore beta o gamma;

- un anticorpo anti-ormone in concentrazione limitata;

- un secondo anticorpo diretto verso il primo anticorpo, che porta alla produzione di un precipitato.

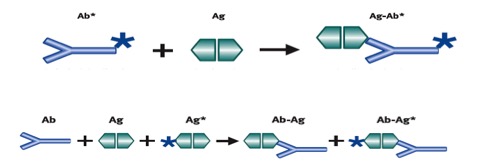

Nella maggior parte dei RIA viene marcato l’antigene. La misurazione nel campione della quantità di antigene non marcato dipende della sua capacità di spiazzare l’antigene marcato (Ag*) dal legame con l’anticorpo (Ab). A questo scopo, l’anticorpo deve reagire e legarsi allo stesso modo sia con l’antigene marcato che con quello non marcato. Gli anticorpi anti-ormone possono essere policlonali, che danno risultati comparabili tra di loro, e monoclonali, che forniscono risultati più bassi, meno comparabili tra i diversi kit e con la capacità di rilevare concentrazioni basse in modo più affidabile. La produzione di anticorpi monoclonali si basa sull’immunizzazione di un topo mediante l’iniezione di un antigene (in questo caso un ormone), che produce nell’animale una risposta anticorpale. Il topo è sacrificato e le cellule che producono anticorpi sono isolate dalla sua milza. La fusione delle singole cellule che producono anticorpi con cellule di mieloma “immortalizzate” è definita “ibridoma”. Tali cellule possono essere coltivate facilmente e contengono grandi quantità di anticorpi identici, poiché derivano da un’unica cellula clonata, detti quindi monoclonali.

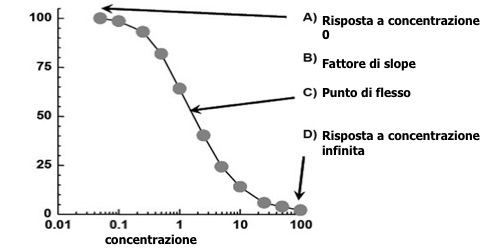

In radioimmunologia possono essere distinti metodi competitivi e non competitivi. Nei metodi competitivi, l’analita non legato a tracciante (non marcato) è misurato dalla sua capacità di “competere” con un analita legato a tracciante per un numero limitato (e fisso) di siti di legame di un anticorpo (fig 2): l’antigene non marcato impedisce all’antigene marcato di legarsi, perché il sito di legame è già occupato. In un metodo competitivo esiste una relazione inversa tra la concentrazione dell’antigene misurato e la concentrazione di antigene legato a tracciante misurato: più antigene “marcato” è legato, meno antigene endogeno è presente nel campione (fig 3).

Figura 2. Metodo competitivo

(Ab = anticorpo, Ag = antigene; Ag-Ab = complesso antigene-anticorpo)

Figura 3. Curva dose-risposta per un metodo immunometrico competitivo

Nei metodi non competitivi (sandwich) (fig 4) l’analita è legato a “sandwich” tra due anticorpi ad alta specificità. La miscela di reazione comprende di norma un eccesso di anticorpo legato al tracciante: tutto l’ormone contenuto nel campione è legato ed il complesso antigene-anticorpo è misurato per determinare la concentrazione presente nel campione. La concentrazione di anticorpo legato al tracciante è, quindi, direttamente proporzionale alla concentrazione di antigene presente nel campione (fig 5).

Figura 4. Metodo sandwich: gli anticorpi si legano a due epitopi sull’analita

Figura 5. Curva dose-risposta per un metodo immunometrico non-competitivo

I metodi immuno-radiometrici (IRMA), in cui il tracciante è legato all’anticorpo, sono oggi poco usati, se non in qualche variante immuno-enzimatica. Attualmente sono più utilizzati i metodi a doppio anticorpo monoclonale a sandwich, che impiegano traccianti enzimatici, fluorescenti e chemi-luminescenti, e possono arrivare a sensibilità analitica (cioè alla minima concentrazione distinguibile da zero) di 0.0001 µg/L. Per esempio, i metodi a sandwich per la determinazione del TSH impiegano, di solito, un anticorpo diretto verso la subunità alfa ed uno verso la subunità beta della molecola glicoproteica eterodimerica del TSH (12).

Numerosi ormoni proteici esercitano i loro effetti legandosi a un recettore di membrana specifico, che, in rapporto con l’adenil-ciclasi, stimola la formazione intracellulare di AMP ciclico. Questi siti recettoriali della membrana cellulare sono stati isolati e utilizzati come composti leganti specifici nel dosaggio radio-recettoriale (RRA). Il principale vantaggio dato dall’uso delle proteine recettoriali, che si ottengono da tessuti differenti e non vengono completamente solubilizzate, nel RRA consiste nel fatto che il recettore misura l’attività biologica, mentre il metodo RIA misura soltanto l’attività immunologica. Tuttavia, le proteine del recettore presentano problemi tecnici considerevoli: sono presenti in piccole concentrazioni, sono instabili, e possono essere danneggiate facilmente nelle procedure di omogeneizzazione e ultra-centrifugazione necessarie per la loro preparazione. Diversi tessuti sono stati impiegati per la messa a punto di metodi RRA.

| Dosaggi RRA | |

| Tessuto | Ormone |

| Proteina del tubulo del testicolo di ratto | FSH |

| Linfociti umani e membrane di epatociti | Insulina, GH |

| Membrane di cellule della ghiandola mammaria | PRL |

| Membrane di cellule tiroidee | Immunoglobuline stimolanti il recettore del TSH |

| Cellule testicolari | hCG |

Il tracciante è sempre più frequentemente enzimatico o chemi-luminescente. Questo tipo di tracciante presenta il vantaggio di consentire l’automazione, permettendo maggiore velocità e precisione, maggiore sensibilità e ampiezza dell’intervallo di misura. I metodi immunologici che richiedono la separazione del complesso Ab-Ag sono definiti eterogenei, mentre quelli che non la richiedono sono definiti omogenei. I metodi omogenei sono in genere più semplici da mettere a punto e sono più facilmente automatizzabili.

Nei metodi competitivi, eterogenei, immuno-enzimatici (ELISA, Enzyme linked immunosorbant assay), i reagenti sono adsorbiti sulla superficie di una fase solida, di solito il pozzetto di una micro-piastra, e l’assorbanza, che è inversamente proporzionale alla concentrazione dell’analita, è misurata con un lettore di micro-piastra.

Per la messa punto dei metodi immuno-enzimatici l’enzima deve:

- essere facilmente reperibile in forma stabile e altamente purificata ad un costo ragionevole;

- essere solubile;

- contenere molti residui di lisina per la coniugazione;

- avere una struttura diversa dagli enzimi presenti nei liquidi biologici in concentrazioni significative.

Il substrato deve:

- essere voluminoso, facilmente reperibile, economico, stabile;

- non trovarsi in significative concentrazioni nei liquidi biologici.

Infine, la reazione enzima-substrato deve:

- avere un pH ottimale che non impedisca la reazione antigene-anticorpo;

- non essere inibita da una qualsiasi sostanza presente nei liquidi biologici;

- avere la possibilità di un arresto del dosaggio semplice, rapido e riproducibile.

Nessuno dei metodi a disposizione del laboratorio clinico per la misurazione degli ormoni possiede le caratteristiche proprie del dosaggio “ideale”.

Autorevoli organizzazioni hanno indicato per alcuni ormoni e test limiti decisionali che hanno validità solo nel contesto clinico e laboratoristico specificato e che possono essere tradotti nelle diverse realtà cliniche solo seguendo raccomandazioni e linee guida aggiornate, attraverso uno stretto collegamento tra l’endocrinologo, l’internista, il medico di medicina generale, il laboratorio di analisi ed il personale infermieristico ed amministrativo che ha la responsabilità delle fasi pre- e post-analitiche. È fondamentale, comunque, avere presente che non è possibile trasferire direttamente i valori di cut-off o decisionali dagli articoli scientifici o dai trattati consultati ai risultati prodotti dal laboratorio che noi utilizziamo, se non sono verificati il metodo e l’analizzatore impiegati, l’unità di misura e lo standard a cui è collegata.

Le differenze tra i risultati ottenuti con i diversi metodi dipendono da fattori diversi e il GH può rappresentare un caso esemplificativo delle problematiche comuni a molti ormoni. I risultati finali dipendono da diversi fattori (13).

- Proteine leganti: i diversi metodi valutano quantitativamente in misura diversa il GH libero, quello legato alle proteine di trasporto e quello totale.

- Isoforme: in circolo sono presenti numerose isoforme, che comprendono monomeri e oligomeri, che cross-reagiscono in modo molto diverso con i vari metodi.

- Problemi di standardizzazione: i metodi di determinazione sono calibrati con materiali di riferimento che sono aggiornati periodicamente.

CASI PARTICOLARI

Metodi basati sul principio dell’analogo. Sono disponibili molti metodi per la determinazione degli ormoni liberi ed in particolare della tiroxina (FT4) e della triiodotironina (FT3). Il metodo di riferimento per la determinazione è quello della dialisi ad equilibrio. La frazione libera del T4 è dapprima separata dalla frazione legata mediante una membrana di dialisi e poi quantificata con una metodica immunometrica tradizionale. Questa tecnica consente una misurazione molto accurata degli ormoni, ma è complessa e non risulta alla portata del laboratorio clinico. Oggi, sono impiegati universalmente metodi basati sul principio dell’”analogo” (14,15). L’FT4 legato a tracciante, che nelle metodiche immunometriche convenzionali compete con l’ormone presente nel siero del soggetto, è sostituito da una molecola “analoga” legata ad un tracciante sufficientemente simile all’ormone endogeno da consentirgli di competere con l’antigene, ma sufficientemente diverso da non legarsi con le proteine vettrici presenti nel siero. La metodica è stata automatizzata, consentendo risultati più rapidi e più precisi e favorendone la rapida diffusione nei laboratori clinici. L’accuratezza dei metodi “analoghi” commercializzati negli ultimi anni è nettamente migliorata e risulta sicuramente confrontabile a quella della dialisi ad equilibrio. È opportuno tuttavia ricordare che, a rigore di termini, la determinazione dell’FT4 mediante il metodo dell’analogo consente non la misura dell’FT4 ma la sua “stima”.

Anticorpi eterofili. Un problema importante nella determinazione del TSH è quello dell’interferenza da anticorpi eterofili, che possono comparire dopo la somministrazione di anticorpi di topo per esami immuno-scintigrafici (questi hanno indotto una reazione immune e conseguente produzione di anticorpi, ma possono essere presenti anche in soggetti che non sono stati sottoposti a trattamenti di questo tipo). Tali anticorpi interferiscono con i metodi di dosaggio basati su anticorpi monoclonali (nella maggior parte dei metodi aumentando la concentrazione del TSH) e possono essere rivelati mediante un loro dosaggio diretto o cimentando il campione con anticorpi particolari che li “bloccano”.

Bibliografia

- Diamandis E, Christopoulos TK. Europium chelate labels in time-resolved fluorescence immunoassays and DNA hybridization assays. Anal Chem 1990, 62: 1149-57.

- Harma H, Soukka T, Lovgren T. Europium nanoparticles and time-resolved fluorescence for ultrasensitive detection of prostate-specific antigen. Clin Chem 2001, 47: 561-8.

- Patrick CW. Clinical flow cytometry: milestones along the pathway of progress. MLO Med Lab Obs 2002, 34: 1-16.

- Vignali DA. Multiplexed particle-based flow cytometric assays. J Immunol Methods 2000, 243: 243-55.

- Rodríguez-Orozco AR, Ruiz-Reyes H, Medina-Serriteño N. Recent applications of chemiluminescence assays in clinical immunology. Mini Rev Med Chem 2010, 10: 1393-400.

- Sternberg J. A rate nephelometer for measuring specific proteins by immunoprecipitin reactions. Clin Chem 1977, 25: 1456-64.

- Miller JM. Chromatography: concepts and contrasts. Wiley Interscience, Malden, MA, 2009.

- Petersson P, Heaton FA, Euerby MR. Maximizing peak capacity and separation speed in liquid chromatography. J Sep Sci 2008, 31: 2346-57.

- Maurer HH. Current role of liquid chromatography–mass spectrometry in clinical and forensic toxicology. Anal Bioanal Chem 2007, 388: 1315-25.

- CLSI. Mass spectrometry in the clinical laboratory. General principles and practice: approved guideline, vol C-50A. Clinical Laboratory Standards Institute, Wayne, PA, 2007.

- Annesley T, Majzoub J, Hsing A, et al. Mass spectrometry in the clinical laboratory: how have we done, and where do we need to be? Clin Chem 2009, 55: 1236-9.

- Rawlins ML, Roberts WL. Performance characteristics of six third-generation assays for thyroid-stimulating hormone. Clin Chem 2004, 50: 2338-44.

- Dorizzi RM. Endocrinologia pediatrica e laboratorio. RIMeL/IJLaM 2007, 3: 28-44.

- Midgley JE. Direct and indirect free thyroxine assay methods: theory and practice. Clin Chem 2001, 47: 1353-63.

- Despres N, Grant AM. Antibody interference in thyroid assays: a potential for clinical misinformation. Clin Chem 1998, 44: 440-54.

Introduzione alle tecniche di patologia

Anna Crescenzi & Eleonora Perrella

UOC di Anatomia Patologica, Campus Biomedico, Roma

L’Anatomia Patologica studia le alterazioni della morfologia dei tessuti e delle cellule che li compongono attraverso l’osservazione macroscopica e microscopica. Strumento essenziale è il microscopio ottico, che permette l'osservazione diretta del materiale con ingrandimenti che consentono la valutazione delle modificazione morfologiche che sottendono alla malattia. Perché tale osservazione sia possibile, i tessuti e le cellule devono essere trattati in modo da prevenirne la decomposizione e permetterne la conservazione e la raccolta su vetrini per la successiva colorazione. Un tessuto che sia stato trattato in questo modo prende il nome di “preparato istologico o citologico”.

1. MATERIALI SOTTOPOSTI AD ESAME IN ANATOMIA PATOLOGICA

1.1 Campioni citologici

Il campionamento del materiale citologico si realizza attraverso 4 tecniche:

- raccolta diretta di cellule spontaneamente esfoliate da organi e cavità del corpo;

- raccolta di cellule mediante manovre meccaniche;

- citologia per apposizione;

- aspirazione di cellule mediante ago sottile.

L’esfoliazione cellulare è un processo che avviene in continuazione ed è correlato al rinnovamento dei tessuti del corpo. Cellule esfoliate spontaneamente si ritrovano nelle urine, nell’espettorato, nei versamenti (pleurico, pericardico, ascitico e sinoviale), nelle secrezioni e nel liquor. Il principale vantaggio di tale tecnica è la facilità con cui si possono ottenere i campioni in molti casi (urine, espettorato). Di contro, i campioni sono spesso costituiti da cellule mal conservate e contaminate da elementi della flogosi, microrganismi e materiale di origine estranea.

Nel campionamento attuato mediante il ricorso a manovre meccaniche (abrasione o scraping, spazzolamento o brushing, lavaggio o washing) le cellule sono rimosse direttamente dal tessuto e pertanto non mostrano modifiche legate alla degenerazione secondaria alla permanenza libera nella cavità campionata (1). L’introduzione nella diagnostica di strumenti a fibre ottiche provvisti di piccole spazzole ha rivoluzionato il campionamento citologico di organi del tratto respiratorio, gastro-intestinale e, in misura minore, del tratto urinario, consentendo l’identificazione di carcinomi iniziali dei bronchi, di carcinomi superficiali dell’esofago e dello stomaco nonché di recidive di carcinomi del colon. È inoltre possibile rimuovere cellule da lesioni non accessibili o non visibili all’endoscopista, dopo instillazione di piccole quantità di soluzioni saline che vengono successivamente aspirate e raccolte in contenitori (lavaggio peritoneale, lavaggio bronco-alveolare, lavaggio della vescica urinaria).

La tecnica della citologia per apposizione sfrutta la capacità delle cellule presenti in un tessuto di aderire a una superficie liscia quale il vetro a seguito di una leggera pressione. È una metodica facile da eseguire, economica, che consente una diagnosi rapida con una sensibilità diagnostica compresa tra 80-85%. È indicata nel caso di lesioni superficiali della cute e linfonodi e trova sempre maggiore applicazione nella diagnostica intra-operatoria (valutazione del linfonodo sentinella nel carcinoma della mammella)(2).

La tecnica di campionamento mediante aspirazione con ago sottile (FNAB) può essere eseguita su organi o lesioni superficiali o profonde (sulle sedi profonde la metodica si realizza sotto monitoraggio radiologico TAC, RMN o Eco-guidata). Sedi di prelievo più frequenti sono tiroide, mammella, linfonodi, ghiandole salivari, fegato, polmone, pancreas e reni. È una metodica facile da eseguire, relativamente economica e che consente la caratterizzazione veloce della natura della lesione, con una sensibilità diagnostica che può raggiungere il 95%. Le complicanze legate a questa procedura sono rappresentate dall’ematoma per lesioni superficiali e dal sanguinamento per lesioni profonde (la metodica non va eseguita in pazienti con difetto della coagulazione). Meno frequenti sono pneumotorace (per lesioni all’interno del torace), perforazione intestinale, pancreatite necrotizzante (per lesioni a sede nell’addome), infarto totale o parziale della lesione e impianto del tumore lungo il tragitto dell’ago (il rischio aumenta con l’utilizzo di aghi di grosso calibro e gli organi più coinvolti sono tiroide, pancreas e rene). La metodica prevede l’utilizzo di aghi non trancianti di piccolo calibro (23-27 gauge), con lunghezza variabile a seconda della profondità dell’organo bersaglio. La manovra può essere eseguita anche senza suzione, quindi senza l’impiego della siringa, con il vantaggio di un migliore controllo dell’ago e un minore traumatismo della lesione (particolarmente indicata per piccole lesioni altamente vascolarizzate, non è raccomandata per l’aspirazione di lesioni cistiche). Condizioni indispensabili per una corretta diagnosi citologica sono l’adeguatezza del campione e il suo corretto allestimento. Il corretto posizionamento dell’ago all’interno della lesione si realizza con il ricorso alle metodiche per immagini; certi di aver centrato il bersaglio, si procede al prelievo. In caso di lesioni di piccole dimensioni (diametro cm 1) è preferibile campionare la periferia, in quanto il centro può essere necrotico. Centrata e trafitta la lesione, si eseguono movimenti di “va e vieni” all’interno di essa con la siringa posta in aspirazione. Per ottenere materiale sufficiente per almeno 2 preparati, sono necessari dai 15 ai 20 movimenti (se l’ago non viene mosso all’interno della lesione si rischia di aspirare solo sangue). Prima di rimuovere l’ago, si rilascia lentamente lo stantuffo onde evitare l’aspirazione di materiale non appartenente alla lesione. Una volta fuori dalla lesione, l’ago viene rimosso dalla siringa. Previa aspirazione di qualche cc di aria nella siringa, questa viene riconnessa all’ago, la cui punta viene posta quasi a contatto con il vetrino su cui viene viene delicatamente spruzzato il materiale (3).

1.2 Campioni bioptici

Il prelievo bioptico è una procedura attraverso la quale si preleva un frammento di tessuto per poterlo analizzare microscopicamente. Il medico pone indicazione all’esecuzione della biopsia quando un esame o una condizione clinica fanno sospettare che quel tessuto sia affetto da patologia (es. evidenza radiologica di nodulo mammario, modificazione di lesione pigmentata della cute, alterazione degli enzimi epatici). Esistono numerosi tipi di biopsia, tutti mirati al prelievo di tessuto da esaminare.

L’agobiopsia è una procedura diagnostica mirata a ottenere un frammento da una massa sita all’interno del corpo. Può essere eseguita a mano libera per neoformazioni relativamente superficiali e ben delineate, oppure sotto guida radiologica per lesioni profonde o mal definibili dal contesto in cui si trovano (es. nodulo intra-ghiandolare in tiroide e ghiandole salivari, nodulo polmonare, ecc). Esistono diversi tipi di aghi bioptici che possono essere attivati manualmente o a molla e con diversa modalità di prelievo: i due sistemi principali sono il tru-cut e il Menghini. Entrambi forniscono un cilindro di tessuto (core biopsy), che viene posto in fissativo immediatamente dopo il prelievo. Il calibro dell’ago determina il diametro del cilindro di tessuto. Un cilindro di maggiori dimensioni aumenta il rischio di sanguinamento e di effetti collaterali, ma fornisce una maggiore disponibilità di materiale per la diagnosi. La scelta del calibro deve pertanto tenere conto di fattori legati al paziente, all’organo e alle caratteristiche della lesione (es estesa necrosi).

Biopsia a pinza endoscopica, broncoscopica, cistoscopica. I prelievi bioptici a pinza endoscopica vengono eseguiti in cavità del corpo raggiungibili mediante apparecchi endoscopici. La pinza, fornita di cavo e manovrata dall’esterno, entra nella cavità attraverso il canale operativo dello strumento e sotto guida ottica viene aperta in corrispondenza della lesione che si intende campionare. Le valve della pinza sono taglienti. Quando la pinza aperta è posta a ridosso della lesione, l’operatore chiude le valve e taglia un frammento di circa 2-3 mm di diametro. La pinza chiusa viene estratta dal canale operativo dell’endoscopio. Una volta estratta, la pinza viene aperta in un contenitore con fissativo dove il frammento liberato resta flottante e inizia il processo di fissazione. Per l’accurata diagnosi della lesione possono essere necessari più passaggi con prelievo bioptico. Alcuni protocolli diagnostici (es la diagnosi di malattia celiaca) richiedono un numero minimo di prelievi bioptici come criterio di adeguatezza.

Biopsia chirurgica. Il prelievo è eseguito con bisturi in un’area accessibile naturalmente (cute, cavo orale), o tramite incisione chirurgica: biopsia a cielo aperto (es nodulo sottocutaneo, nodulo della mammella, linfonodo superficiale) o per via laparoscopica (linfonodi profondi, formazioni peritoneali). Quando l’intera area è rimossa, si parla di biopsia escissionale, quando solo una parte della lesione è campionata a scopo diagnostico per programmare l’estensione dell’intervento di parla di biopsia incisionale. La biopsia chirurgica è detta anche tumorectomia, se con l'intervento chirurgico si procede alla rimozione della lesione sospetta (es nodulo mammario).